A l’occasion de la Robocup 2023, qui est la plus grande compétition de robotique domestique mondiale, l’équipe LyonTech, composée d’étudiants, chercheurs et ingénieurs en IoT et Robotique, a fait concourir son robot PALbator. Ce robot peut se déplacer de manière autonome, reconnaître et identifier les personnes et les objets dans son environnement et interagir avec des interlocuteurs de manière précise.

La participation à cette compétition permet d’une part de se challenger contre des équipes venues du monde entier, mais surtout de faire avancer les progrès en termes de robotique domestique. Ces avancées vont permettre de faciliter la vie quotidienne de tout individu, et surtout des personnes handicapées et âgées, en leur apportant un soutien et une assistance personnalisée.

Robot PALbator

Le pouvoir de la vision

Imaginez un robot capable de reconnaître instantanément, par la vision et le son de votre voix, vos demandes afin de lui indiquer d’apporter ou de déplacer des objets, ou même d’ouvrir des portes. C'est précisément ce dont nous allons discuter dans ce projet de robotique de service.

Pour atteindre cet objectif, nous devions examiner les différents éléments nécessaires à sa réalisation : caméras, bras, software, interfaces d’interactions, micros, etc.

Voici donc l’expérience de l’équipe sur le choix et la mise en œuvre de ce projet.

La caméra 3D OAK-D :

Le premier composant essentiel pour observer l’environnement est une caméra. Mais cette caméra est assez spéciale car elle permet, grâce à sa vision stéréo, de voir en profondeur. Mais ce n’est pas tout, elle embarque une puce Myriad X d’Intel, dotée d’une impressionnante puissance, lui permettant d’exécuter des modèles d’Intelligence Artificielle, le tout pour un tarif assez compétitif. C’est pour tous ces avantages que la caméra OAK-D a été choisie.

Caméra OAK-D

La détection des mains

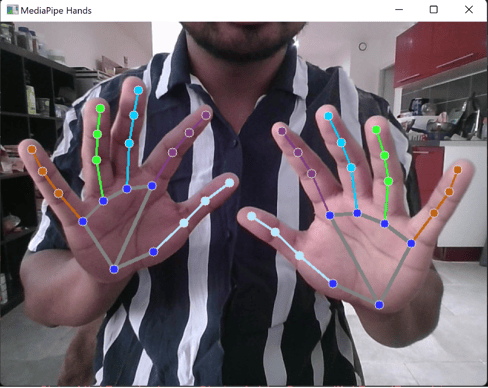

Pour détecter l’objet qu’un utilisateur pointe, il est nécessaire d’observer ses mains. Ainsi, l’outil Mediapipe, créé et fourni par les équipes de Google, permet de détecter et de tracker des mains depuis une image fournie par la caméra. Il est alors possible de déterminer les coordonnées spatiales de 21 points clés de la main. Avec ces 21 marqueurs, il est alors possible de repérer si une main est en train de pointer et sa direction dans l’espace grâce à l’information de profondeur obtenue grâce à la caméra 3D.

Détection de la position des mains avec Mediapipe

21 landmarks de la main détectés par le réseau de neurones

21 landmarks de la main détectés par le réseau de neurones

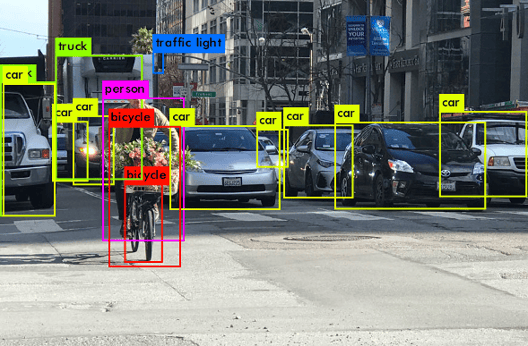

La détection d'objets

L’identification des objets dans le champ de vision de la caméra requiert l’utilisation d’une Intelligence Artificielle, qui sera capable de reconnaître des caractéristiques dans les pixels d’une image. La caméra utilisée embarque également ce genre de modèle et c’est ainsi que YOLOv5 a été utilisé, alliant une excellente capacité de détection ainsi qu’une bonne rapidité d’exécution. Grâce à son intégration native dans la caméra, il est donc aisé de combiner ce réseau de neurones à celui de la détection des mains et permettre une parallélisation du processus.

Exemple de détection d’objets via YOLOv5

L'interaction entre la main et les objets

Permettre de reconnaitre quel objet est pointé par l’utilisateur passe par un traitement des données en combinant les informations de position de la main avec celles des objets détectés. Une ligne virtuelle est créée, émanant de l’index de l’utilisateur. Chaque objet traversé par cette ligne sera traité et finalement, seul le plus proche sera gardé et qualifié d’objet pointé par l’utilisateur.

Résultat du code lors d’une détection de chaise

Résultat du code lors d’une détection de chaise

Les possibilités infinies

En conclusion, l'utilisation de réseaux de neurones pour la détection des mains et des objets ouvre un monde de possibilités. Que ce soit dans le domaine de l'interaction homme-machine, de la réalité augmentée, de l'assistance robotique, du contrôle de jeux vidéo, de la sécurité et de la surveillance, ou même de l'assistance médicale, notamment les personnes en situation de handicap, la technologie leur permet d’être entièrement autonomes, elle est immersive et intuitive.

N'hésitez pas à nous faire part de vos commentaires et à partager vos idées sur l'avenir passionnant de la robotique de service alimentée par la vision 3D et l'intelligence artificielle.